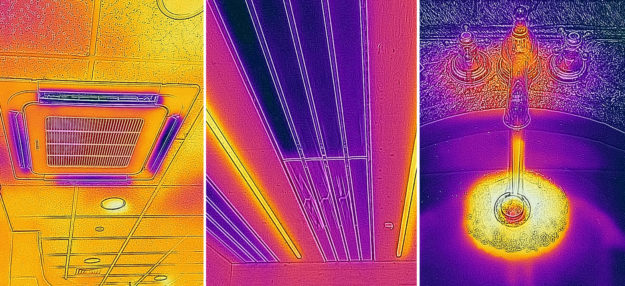

Il est essentiel de concevoir des politiques de contrôle thermique des bâtiments efficaces sur le plan énergétique, qui permettent de réduire la consommation d'énergie opérationnelle des systèmes CVC dans les bâtiments. En général, les températures dans les bâtiments sont maintenues dans des limites étroites, ce qui entraîne une consommation d'énergie opérationnelle plus élevée. De plus, pour une exposition à long terme, un tel environnement n'est pas forcément le meilleur pour les occupants.

Des études suggèrent qu'un environnement dynamique pourrait être plus sain pour le corps humain. Cependant, il est difficile de mettre en œuvre une telle politique de contrôle, en tenant compte de l'efficacité énergétique du système HVAC, de l'environnement intérieur dynamique et des exigences d'acceptabilité thermique. Les nombreux facteurs influencent la politique de contrôle dans un tel cas et la mise en œuvre d'une politique de contrôle prenant en compte tous les paramètres est un défi et généralement difficile à modéliser car ils peuvent différer d'un cas à l'autre.

Pour résoudre cette complexité, nous développons un cadre basé sur l'apprentissage par renforcement profond (DRL) pour l'optimisation énergétique et le contrôle de l'environnement thermique sain dans les bâtiments. Comme la plupart des variables de contrôle sont continues dans les bâtiments, un nouvel algorithme DRL appelé gradient de politique déterministe profonde (DDPG) est mis en œuvre.